时间飞快,马上就迎来了 2021 年,又到了总结自己这一年来的所有的经历和收获的时候了。

2020 是非比寻常的一年,对于每个人不论是生活还是工作,都因为新冠病毒被影响着。

但生活总归要继续。刷微博、抖音各种社交媒体是一天;工作学习也是一天。我是那种一段时间感觉没进步就特别恐慌的人,做完后者总会让我感觉更安心一些。

回顾 2020

关于工作

对于 2020 年,我一直努力想要去做到最好,年尾回头看看,还算满意吧。

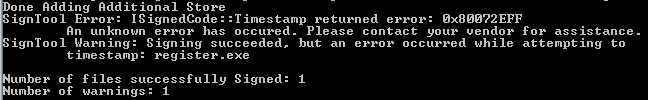

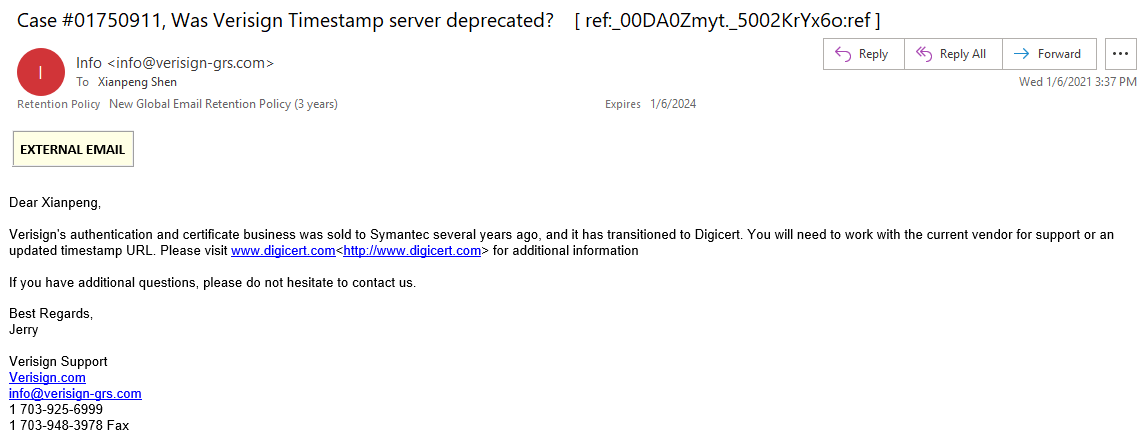

在年底写下工作工作总结的时候,发现自己这一年确实做了很多工作。除了做好构建和发布的本职工作之外,做了很多改进流程和提高效率工作,捡一些重要的来说:

作为 DevOps/软件工程师还需要有良好的表达能力,否则你做的东西再好,但无法很清晰的跟同事及领导分享出来也是事倍功半。尤其像我在外企,还需要用英文去做分享。

另外,我想通过坚持阅读和实践,让自己在技术上有比较大的提高。有一段时间我坚持的比较好,完成了好几本技术书籍的阅读,但好的习惯就怕被打破,一旦被打破就很难坚持了。之前一般都是中午午休的时间会阅读半个小时以上的技术书,后来常常因为中午要去新房盯装修,加上每天要做的事情很多(工作、学英语、阅读、装修)的时候,很多时候往往是事情做了,但效果并没有达到预期。

分享上

2020 年博客上一共更新了 41 篇文章,在公众号『DevOps攻城狮』上面一共更新了 26 篇文章。

这个数量和质量跟一些其他的技术公众号真的没法比,但对于我个人:一个不以写作为生、只写原创文章的攻城狮,只要能不间断的输出,达到这个数量我已经比较满意了。

而且在年初有一个清华大学的编辑老师找到我,想让我出一本书,这真是让我受宠若惊。我知道自己几斤几两,但能够受到邀请,并寄给我合同,就已经是对我写作的最大鼓励了。

当时打算写一本《Jenkins 2实践指南》,如果签了合同,我就需要投入至少一年的业余时间死磕自己才有可能完成。

最后考虑到自己当时的状况:优先做好工作;其次还有比Jenkins更重要的技术我需要去学习;另外周末要装修等一系列的事情…我最终放弃了这个机会。

我知道自己还处在输入比输出更加迫切的阶段,我想只要心中的小火苗还在,但行好事,莫问前程。

工作 flag

对于个人年终总结,不仅可以回顾自己过去的一年做了哪些,哪些没做好,有什么可以改进的,还能通过回顾和总结为新年立一个 flag。

2021 我希望自己能更加专注,利用好时间,更加有效的工作和学习。

除了做好工作,最重要的是提高英语口语和深入学习技术,其次才是输出。

光有 flag 不行,还要落到具体的行动上。

提高英语口语

🚩 2021 继续坚持至少每天半小时口语打卡练习;另外每周一次 50 分钟的与外教的口语交流。希望能够脱稿进行英文分享,同时能通过英语托业考试。

深入学习技术

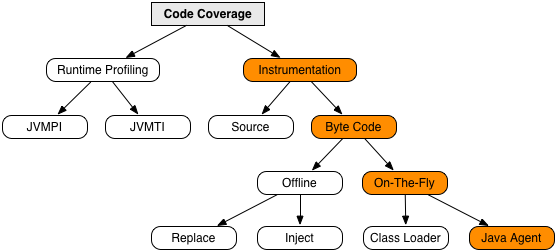

我现在学习技术的方式有这么几种:直接去官网阅读英文文档;如果读完还是没搞明白,就去 Linkedin Learning 或是 Udemy 上去搜相应的技术,不但学习了技术,同时也练习了英文听力;如果需要深入系统的去学习一门编程语言以及一些底层技术,会去读一些经典技术书籍。

🚩 2021 年坚持每天也至少半个小时来阅读技术,一个月至少读完一本技术书籍并且有输出。

生活 flag

生活上希望家人和朋友都能身体健康,生活幸福。

🚩 财务稳定,最好能增长;自己能够健康生活,减重 10 斤。

最后,不时的来回顾自己 2021 年的 flag,时不时的看看自己是否偏离了最初的方向。2021 我来了!

过去的年终总结

2019 年终总结

2018 从测试到开发的五个月